Файл Robots.txt — зачем он нужен и как его создать? Правильные сборки

14.02.2017

Содержание статьи

- Что такое Robots.txt и зачем он нужен

- Как он влияет на продвижение Вашего сайта?

- Где он находится?

- Что Вы должны знать о файле Robots.txt

- Как закрыть от индексации страницу, раздел, файл?

- Что обязательно должно быть в Вышем файле Роботс.тхт

- Указание главное зеркала

- Как проверить Robots.txt ?

- Мои сборки для разных CMS

Приветствую Вас друзья и подписчики моего блога. Сегодня на повестке дня Robots.txt, все что Вы хотели о нем знать, вкратце, без лишней воды.

В ближайшее времени я буду проводить свой авторский курс по обучению SEO (оптимизации и продвижению сайтов), рекомендую ознакомиться!

- Что такое Robots.txt и зачем он нужен

- Как он влияет на продвижение Вашего сайта?

- Где он находится?

- Что Вы должны знать о файле Robots.txt

- Как закрыть от индексации страницу, раздел, файл?

- Что обязательно должно быть в Вышем файле Роботс.тхт

- Указание главное зеркала

- Как проверить Robots.txt ?

- Мои сборки для разных CMS

Что такое Robots.txt и зачем он нужен

Robots.txt нужен для того, чтобы указать поисковику (Яндексу, Google и др.) как правильно (с Вашей точки зрения) нужно индексировать сайт. Какие страницы, разделы, товары, статьи нужно индексировать, а какие наоборот, не нужно.

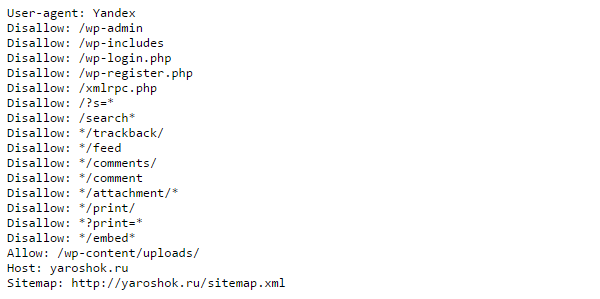

Robots.txt это обыкновенный текстовый файл (с разрешением .txt) , который был принят консорциумом W3C 30 января 1994 года, и который используют большинство поисковых систем, и выглядит он обычно так:

Как он влияет на продвижение Вашего сайта?

Для успешного продвижения сайта необходимо, чтобы в индексе (базе) Яндекса и Google были только нужные страницы сайта. Под нужными страницами я понимаю следующие:

- Главная;

- страницы разделов, категорий;

- Товары;

- Статьи;

- Страницы «О компании», «Контакты» и т.п.

Под НЕ нужными страницами я подразумеваю следующие:

- Страницы-дубликаты;

- Страницы печати;

- Страницы результатов поиска;

- Системные страницы, страницы регистрации, входа, выхода;

- Страницы подписки (feed);

и др.

К примеру, если в индексе поисковика будут находиться дубликаты основных продвигаемых страницы, то это вызовет проблемы с уникальностью контента внутри сайта, а также негативно повлияет на позиции.

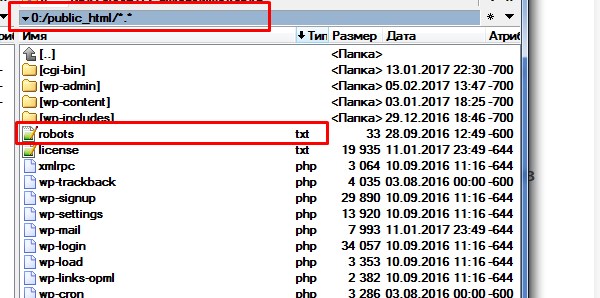

Где он находится?

Файл как правило лежит в корне папки public_html на Вашем хостинге, вот здесь:

Что Вы должны знать о файле Robots.txt

- Инструкции robots.txt носят рекомендательный характер. Это значит, что настройки являются указаниями, а не прямыми командами. Но как правило, и Яндекс и Google следуют указаниям без всяких проблем;

- Файл может размещаться только на сервере;

- Он должен лежать в корне сайта;

- Нарушение синтаксиса ведет к некорректности файла, которое может негативно сказаться на индексации;

- Обязательно проверяйте правильность синтаксиса в панели Яндекс Вебмастер!

Как закрыть от индексации страницу, раздел, файл?

Например, я хочу закрыть от индексации в Яндексе страницу: http://yaroshok.ru/page-for-robots/

Для этого, мне необходимо использовать директиву «Disallow» и URL страницы (раздела, файла). Выглядит это следующим образом:

User-agent: Yandex

Disallow: /page-for-robots/

Host: yaroshok.ru

Если я захочу закрыть категорию http://yaroshok.ru/category/case/, то необходимо будет сделать так:

User-agent: Yandex

Disallow: /category/case/

Host: yaroshok.ru

Если я захочу закрыть весь сайт от индексации, кроме раздела http://yaroshok.ru/category/case/, то необходимо будет сделать так:

User-agent: Yandex

Disallow: /

Allow: /category/case/

Host: yaroshok.ru

Директива «Allow», наоборот, говорит о том, какую страницу, раздел, файл, нужно индексировать.

Думаю логика построения Вам стала понятна. Обратите внимание, что правила будут действовать только для Яндекса, так как указан User-agent: Yandex. Google же, будет игнорировать эту конструкцию и будет индексировать весь сайт.

Если хотите написать универсальные правила для всех поисковых систем, используйте: User-agent: *. Пример:

User-agent: *

Disallow: /

Allow: /category/case/

Host: yaroshok.ru

User-agent — это имя робота, для которого предназначена инструкция. По умолчанию стоит * (звёздочка) — это означает, что инструкция предназначена для абсолютно всех поисковых роботов.

Наиболее распространённые имена роботов:

- Yandex — все роботы поисковой системы Яндекса

- YandexImages — индексатор изображений

- Googlebot — робот Гугла

- BingBot — робот системы Bing

- YaDirectBot — робот системы контекстной рекламы Яндекса.

Ссылки на детальный обзор всех директив Яндекса и Google.

Что обязательно должно быть в Вышем файле Роботс.тхт

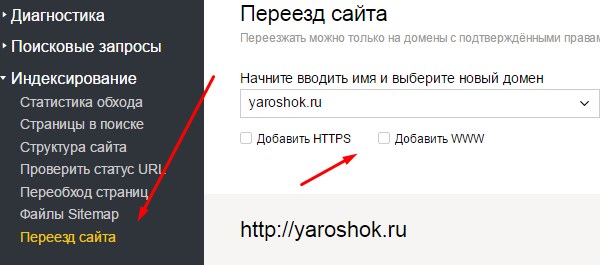

- Настроена Директива Host. В ней должно быть прописано основное зеркало Вашего сайта. Основные зеркала: site.ru или www.site.ru. Если Ваш сайт с https, то это также обязательно должно быть указано. Основное зеркало в host и в Яндекс.Вебмастер должно совпадать.

- Должны быть закрыты от индексации (директивой Disallow:) разделы и страницы сайта, не несущие полезной нагрузки, а также страницы с дублями контента, страницы печати, результатов поиска и системные страницы.

- Укажите ссылку на sitemap.xml (карту Вашего сайта в формате xml).

Sitemap: http://site.ru/sitemap.xml

Указание главное зеркала

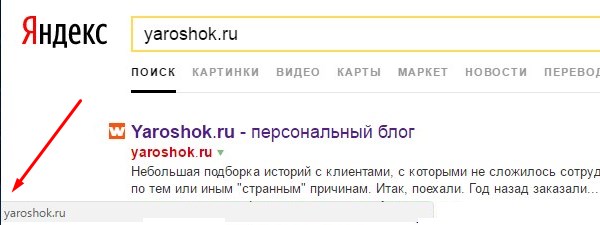

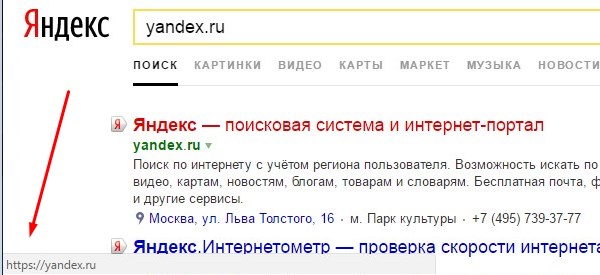

Сперва необходимо узнать, какое зеркало у Вас главное по умолчанию. Для этого введите URL вашего сайта в Яндексе, наведите на URL в выдаче и слева внизу в окне браузера будет указано, с www домен, или без. В данном случае, без WWW.

Если домен указан с https, то и в Robots и в Яндекс.Вебмастер необходимо указать https! Выглядит это следующим образом:

После того, как Вы определились с главным зеркалом Вашего сайта, укажите его в Robots.txt и в webmaster.yandex.ru.

Как проверить Robots.txt ?

Чтобы проверить правильность написания файла и директив в нем, а также узнать, закрывает ли он нужны страницы (разделы, рубрики, файлы), зайдите в панель Яндекс.Вебмастер => Инструменты => Анализ Robots.txt.

Мои сборки для разных CMS

- Robots.txt для WordPress

- Robots.txt для Joomla 2.5 и 3 с родным SEF и Robots.txt для Джумла + VirtueMart + SH404

- Robots.txt для Bitrix

Не забудьте заменить «ВашСайт.ру» на URL Вашего сайта.

На сегодня все. С Вами был Ярошок Дмитрий, подписывайтесь на канал!

Скажите пожалуйста, а страницы категорий закрываются от индексации рекурсивно, включая все страницы, относящиеся к этой категории?

Если вы закроете категорию через disallow /category/

то все что в ней, тоже будет закрыто.

Если нужно закрыть только страницу категорий, но внутренние статьи оставить, тогда нужно писать

Disallow: /category/case/$

т.е. знак $ на конце означает, что вы закрываете только эту страницу.

Но советую проверять все через яндекс вебмастер, там можно протестировать.